版权说明:本文档由用户提供并上传,收益归属内容提供方,若内容存在侵权,请进行举报或认领

文档简介

第三讲神经网络的学习规则和感知器主讲内容◆§3.1机器学习与神经网络学习◆§3.2几种神经网络学习规则◆

§3.3感知器学习规则、算法以及收敛性

定理◆§3.4本讲问题本章目的:①介绍各种学习算法的数学原理、分析学习性质;②说明算法的使用。(不讲有关的算法的生理学、生物学原理)第三讲神经网络的学习规则和感知器┃主讲人方涛§3.1机器学习与神经网络学习3.1.1机器学习3.1.2神经网络学习及其分类第三讲神经网络的学习规则和感知器┃主讲人方涛3.1.1机器学习

机器学习━━AI的一个分支学科

§3.1机器学习与神经网络学习

人类学习行为(客观世界)→研究归纳、类比等基本方法→获取各种知识和技能。机器学习→了解人类的各种学习过程→建立各种学习模型→赋予机器的学习能力。有了学习能力,才能不断自我完善,自我校正,自动获取和发现新的知识……

没有机器学习的系统不会是一个真正的智能系统。机器学习目前已经有:事例学习、遗传学习、类比学习……

第三讲神经网络的学习规则和感知器┃主讲人方涛§3.1机器学习与神经网络学习机器学习的发展历史:①20世纪50年代中期

研究没有任何初始知识的通用学习系统,尤其是神经网络系统。

主要特点:数值表示和参数调整,比如感知机、生物进化过程模拟等。AI:符号表示和启发式方法,即偏于模式识别②20世纪60年代初期

概念学习和语言获取。

主要特点:符号表示(已成为AI主要方法)③20世纪70年代中后期专家系统和知识工程形成,对知识尤为关注,兴盛时期。④20世纪80年代中后期

源于神经网络的重新兴起,使非符号的神经网络研究和符号学习得以深入开展。

第三讲神经网络的学习规则和感知器┃主讲人方涛§3.1机器学习与神经网络学习机器学习的发展历史:⑤20世纪90年代

有限样本统计理论线性空间表示,Vapnik:SVM(1991);

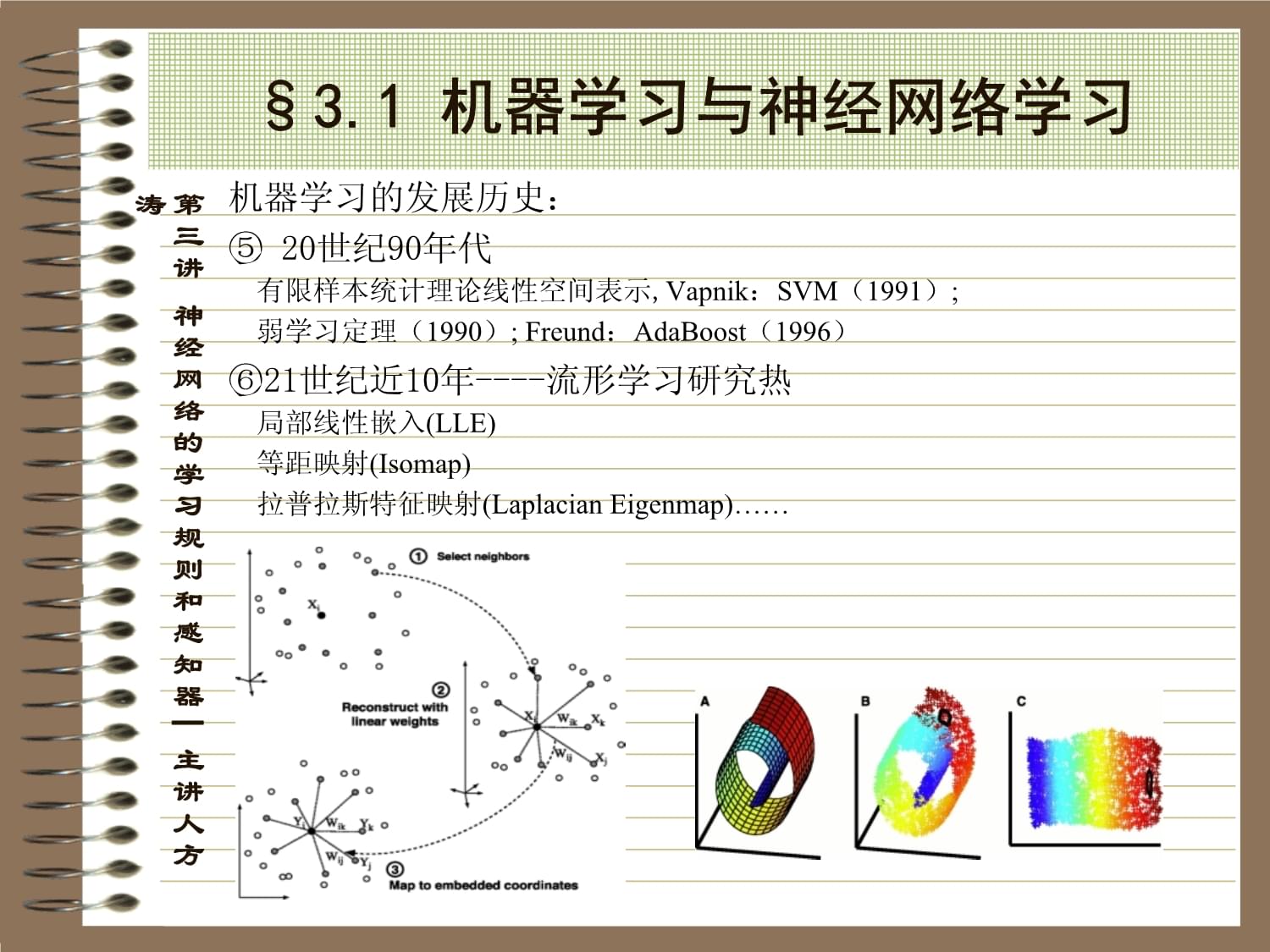

弱学习定理(1990);Freund:AdaBoost(1996)⑥21世纪近10年----流形学习研究热局部线性嵌入(LLE)

等距映射(Isomap)

拉普拉斯特征映射(LaplacianEigenmap)……

第三讲神经网络的学习规则和感知器┃主讲人方涛17对象的层次性流形(HML)构造高维特征空间的层次性流形学习◆流形学习降维研究目标高维特征低维嵌套的非线性映射,提供目标特性低维表达的有效方式

LLE、ISOMap、LaplacianEigenmap、HessianEigenmap等多子流形◆多类别高分影像对象广泛存在大类、小类等层次性结构单一结构的流形难以更准确进行非线性映射◆层次性流形(HML)不同类别、不同层次的多个子流形父流形与子流形间关系,通过自下而上“共

享特征”实现层次性邻及矩阵18◆流形学习降维广义回归神经网络GRNN解决out-of-sample通过层次性流形(HML)降维,解译精度比单一流形性能显著提高高维特征空间的层次性流形学习该方法得到了国际同行评价“Thisisacompletelyvalidapproachfromapragmaticperspective,andcanevenleadtobetterresults”§3.1机器学习与神经网络学习3.1.2神经网络学习及其分类人工神经网络的主要学习算法:3.1.2.1有无导师的学习方式

与机器学习类似:事例学习、无导师学习、死记式学习…。主要分为:①监督学习(有导师学习)

依据期望值与实际网络输出值之差来调整连接权,因此需要有导师来提供期望值。

将训练样本的数据加入到网络输入端,由期望输出与网络输出得到误差信号,由此控制连接权的调整,多次训练使得连接权收敛到某个确定值。

反传网络、感知器、LVQ算法、广义规则……第三讲神经网络的学习规则和感知器┃主讲人方涛§3.1机器学习与神经网络学习②非监督学习(无导师学习)

神经元仅根据I/O来修正连接权。直接将网络置于环境中,学习阶段与工作阶段于一体,具有自适应性。

比如:Hebb学习规则(简单),竞争学习(复杂)、ART、自组织映射…③强化学习

(有导师学习的特例)

采用“评论员”来评价与给定输入相对应的神经网络输出的优度(质量因子)。

典型例子:遗传算法(Gas)。3.1.2.2来自环境刺激模式的多少分类①联想式学习②非联想式学习第三讲神经网络的学习规则和感知器┃主讲人方涛§3.1机器学习与神经网络学习3.1.2.3网络连接方式来分①阶层②相互连接

一旦神经网络的拓扑结构确定后,学习就是连接权的修正。学习模型:第三讲神经网络的学习规则和感知器┃主讲人方涛§3.2几种神经网络学习规则3.2.1Hebb学习规则3.2.2剃度下降算法与学习规则3.2.3其它几种学习规则第三讲神经网络的学习规则和感知器┃主讲人方涛§3.2几种神经网络学习规则3.2.1Hebb学习规则

Hebb(美国心理学家)1949年提出假说(OrganizationofBehavior):“如果两个神经元A和B有一个共同的突触S,那么当两个神经元同时兴奋时,突触的强度增强。”

规则:当第i个和第j个神经元同时处于兴奋状态时,其连接权加强。(最简单的非监督学习)学习速率参数(训练速率参数)、输入输出权的初始化:在0附近取很小的随机值。第三讲神经网络的学习规则和感知器┃主讲人方涛§3.2几种神经网络学习规则3.2.2剃度下降算法与学习规则

①剃度下降算法的一般形式

其中E为误差函数。

误差反传训练算法(BP)就是由梯队算法推导出来的,收敛速度慢。②学习训练算法(最小均方规则)

学习规则:用神经元的输出值与期望值之间的最小平方误差来调整连接权。第三讲神经网络的学习规则和感知器┃主讲人方涛§3.2几种神经网络学习规则

剃度向量

标量

令

标量可以推广于多层网络。学习训练算法为剃度下降算法的一个特例。

第三讲神经网络的学习规则和感知器┃主讲人方涛§3.2几种神经网络学习规则3.2.3其它几种学习规则

①内外星学习规则Grossberg1974年提出来的,由信号的流向确定是内星还是外星。

内星:节点通过连接权接受一组输入信号。

连接权的学习规则:第三讲神经网络的学习规则和感知器┃主讲人方涛§3.2几种神经网络学习规则

外星:节点通过连接权输出一组信号。

连接权的学习规则:②Winner-Take-All(胜者为王)学习规则(无)③随机训练算法(概率/能量)④模拟退火算法⑤Widrow-Hoff学习规则……第三讲神经网络的学习规则和感知器┃主讲人方涛§3.3感知器学习规则、算法以及收敛性定理第三讲神经网络的学习规则和感知器┃主讲人方涛3.3.1感知器学习规则及算法3.2.2简单感知器的局限性3.2.3感知器的收敛性Theconceptualschemefor‘learning’inthiscontextisamachinewithaninputchannelforfigures,apairofYESandNOoutputindicators,andareinforcementor‘reward’buttonthatthemachine’soperatorcanusetoindicatehisapprovalordisapprovalofthemachine’sbehavior.”——M.L.MinskyandS.A.Papert,“Perceptron”(1988)§3.3感知器学习规则、算法以及收敛性定理第三讲神经网络的学习规则和感知器┃主讲人方涛3.3.1感知器学习规则及算法

感知器(perceptron)是1957年美国Rosenblatt提出的单层计算单元的网络,相当于一个神经元。也称线性阈值单元(LTU)。§3.3感知器学习规则、算法以及收敛性定理第三讲神经网络的学习规则和感知器┃主讲人方涛

在感知器中,连接权是可以改变的,即可以学习训练的。Rosenblatt已证明如果两类模式是线性可区分的,则算法一定会收敛,即连接权一定会存在,否则在分类边界产生震荡,使连接权不收敛。

学习规则:

学习信号(或导师信号):期望值d与实际输出值之差。连接权的调整形式:学习速率参数常常,有助于训练规则朝正确解收敛,太小,将产生慢收敛,太大,将可能引起震荡。§3.3感知器学习规则、算法以及收敛性定理第三讲神经网络的学习规则和感知器┃主讲人方涛

迭代算法过程:①确定初始值,包括连接权较小的非零随机值(包括阈值);②输入不同的训练样本和导师信号d或者期望的输出;③计算实际输出④修正连接权⑤转入②步,重复②~④的步骤,直到连接权向量收敛,停止迭代训练过程。ANN的学习过程就是训练过程,在将训练样本集输入到网络的过程中,按照一定的方式来调整神经元之间的联结权重值,使得网络能够将训练样本集的内涵以联结权重矩阵的方式存储起来,从而使得网络在接受输入时,能够给出适当的输出。

§3.3感知器学习规则、算法以及收敛性定理第三讲神经网络的学习规则和感知器┃主讲人方涛3.3.2简单感知器的局限性

仅能进行简单的线性分类和解决一阶谓词逻辑。W/|W|二维的广义线性可分离方程:n维的广义线性可分离方程:§3.3感知器学习规则、算法以及收敛性定理第三讲神经网络的学习规则和感知器┃主讲人方涛3.3.2简单感知器的局限性

“线性不可分”问题的困境及其解决1969年,Minsky和Papert在“Perceptron”一书中从理论上证明单层感知器无法解决许多简单的问题,包括“异或(XOR)”问题。使得ANN理论的发展在1970~80年代处于低潮。导致政府和企业资助减少,研究人员撤退……MarvinMinskyMITMediaLabandMITAILab

ToshibaProfessorofMediaArtsandSciences

ProfessorofE.E.andC.S.,M.I.T

§3.3感知器学习规则、算法以及收敛性定理第三讲神经网络的学习规则和感知器┃主讲人方涛对异或(Exclusive-OR-XOR)问题,无法求解。XORy01x001110XOR是一个双输入、单输出问题。对应的单层感知器为:xyabzax+by=xy无论如何选择参数a,b,,都无法满足划分。这种由单层感知器不能表达的问题称为线性不可分问题。尽管简单感知器学习算法有局限性,但是它还是给出了单个神经元的自组织、自学习的算法,对神经网络研究有其重要意义。§3.3感知器学习规则、算法以及收敛性定理第三讲神经网络的学习规则和感知器┃主讲人方涛3.3.3感知器的收敛性

收敛定理:(1958年Rosenblatt里程碑式的进展)

假设函数线性可分,那么经过感知器学习算法有限次迭代后,可以收敛到正确的权值或者权向量。

假定①训练样本为单位向量;②依据函数的线性可区分性,将所有小于0的输出都归化为大于0的输出,即

则以替换,则有

只需证明:如果存在使得则

下列

温馨提示

- 1. 本站所有资源如无特殊说明,都需要本地电脑安装OFFICE2007和PDF阅读器。图纸软件为CAD,CAXA,PROE,UG,SolidWorks等.压缩文件请下载最新的WinRAR软件解压。

- 2. 本站的文档不包含任何第三方提供的附件图纸等,如果需要附件,请联系上传者。文件的所有权益归上传用户所有。

- 3. 本站RAR压缩包中若带图纸,网页内容里面会有图纸预览,若没有图纸预览就没有图纸。

- 4. 未经权益所有人同意不得将文件中的内容挪作商业或盈利用途。

- 5. 人人文库网仅提供信息存储空间,仅对用户上传内容的表现方式做保护处理,对用户上传分享的文档内容本身不做任何修改或编辑,并不能对任何下载内容负责。

- 6. 下载文件中如有侵权或不适当内容,请与我们联系,我们立即纠正。

- 7. 本站不保证下载资源的准确性、安全性和完整性, 同时也不承担用户因使用这些下载资源对自己和他人造成任何形式的伤害或损失。

最新文档

- 2026海南省第二人民医院招聘药学人员4人备考题库(一)及答案详解(夺冠系列)

- 2026河北雄安宣武医院选聘工作人员262人备考题库参考答案详解

- 2026福建漳平市国有资产投资集团有限公司招聘5人备考题库附参考答案详解(模拟题)

- 2026浙江杭州市临平区崇信小学招聘第二学期编外教师2人备考题库含答案详解(预热题)

- 2026海南澄迈县教育部直属师范大学公费师范毕业生招聘13人备考题库及答案详解(网校专用)

- 2026江西赣州市龙南市殡葬服务中心招聘会计人员1人备考题库附参考答案详解(考试直接用)

- 2026贵州铜仁市德江县考调城区小学紧缺学科专任教师26人备考题库附答案详解

- 2026浙江中医药大学附属第三医院(第三临床医学院康复医学院)博士后招聘27人备考题库含答案详解ab卷

- 2026黑龙江齐齐哈尔市富裕县房产和物业服务中心招聘公益性岗位人员2人备考题库附参考答案详解(满分必刷)

- 2026福建泉州市南安市文昌实验幼儿园招聘专任教师、保育员、保健医生备考题库含答案详解(预热题)

- 广东省实验中学2025-2026学年高二上学期期末练习语文试题(含答案)(含解析)

- 九上《水浒传》整本书阅读真题汇编+详细解析

- 医院消防安全宣传教育

- 医院感染管理基本知识培训

- TSHXCL 0021-2024 温差电致冷组件用晶棒

- DL∕T 1290-2013 直接空冷机组真空严密性试验方法

- 亚马逊全球开店:2024亚马逊日本机会品类动向调查报告-床上用品

- 水岸·琉璃园-山东淄博留仙湖公园景观设计

- 人教版三年级上册脱式计算200题及答案

- 2023人教版 四年级下册数学 第二单元测试卷(含答案)

- 微型课题研究的过程与方法课件

评论

0/150

提交评论