版权说明:本文档由用户提供并上传,收益归属内容提供方,若内容存在侵权,请进行举报或认领

文档简介

分布式存储系统:AmazonS3:S3访问控制与安全策略1理解AmazonS31.1S3的基本概念AmazonSimpleStorageService(S3)是亚马逊云科技提供的一种对象存储服务,用于在互联网上存储和检索任意数量的数据,从任何地方。S3提供了高可扩展性、数据可用性、安全性以及极低的延迟时间,使其成为存储和访问数据的理想选择,无论是用于备份和归档,还是用于实时数据处理和分析。1.1.1特点高可扩展性:S3可以存储无限数量的对象,每个对象可以是任意大小,从零字节到数TB。数据持久性:S3提供了99.999999999%的数据持久性,确保数据的长期存储。全球访问:S3在全球多个地区提供服务,数据可以被快速访问,无论用户位于何处。安全性和隐私:提供了多种安全选项,包括访问控制列表(ACLs)、存储桶策略、加密等,确保数据的安全。1.2S3的架构与组件AmazonS3的架构设计围绕着两个核心概念:存储桶和对象。1.2.1存储桶(Bucket)定义:存储桶是S3中的容器,用于存储对象。每个对象都必须属于一个存储桶。命名规则:存储桶名称是全局唯一的,且必须遵循特定的命名规则,例如,只能包含小写字母、数字、点和连字符。位置:存储桶在创建时需要指定一个区域,数据将被存储在该区域的S3数据中心。1.2.2对象(Object)定义:对象是存储在S3中的数据实体,由数据体、元数据和一个唯一键组成。键(Key):对象的键是其在存储桶中的唯一标识符,用于检索数据。元数据:可以附加到对象上的任意数量的键值对,用于描述对象的属性。1.2.3示例:创建存储桶和上传对象importboto3

#创建S3客户端

s3=boto3.client('s3')

#创建存储桶

bucket_name='my-unique-bucket-name'

s3.create_bucket(Bucket=bucket_name,CreateBucketConfiguration={'LocationConstraint':'us-west-2'})

#上传对象

file_path='/path/to/your/file.txt'

object_key='file.txt'

s3.upload_file(file_path,bucket_name,object_key)

#设置对象的ACL

s3.put_object_acl(Bucket=bucket_name,Key=object_key,ACL='public-read')1.2.4解释上述代码示例展示了如何使用Python的boto3库与AmazonS3进行交互。首先,我们创建了一个S3客户端,然后使用create_bucket方法创建了一个名为my-unique-bucket-name的存储桶,指定其位于us-west-2区域。接着,我们使用upload_file方法将本地文件file.txt上传到该存储桶。最后,我们通过put_object_acl方法设置了对象的访问控制列表(ACL),使其对公众可读。1.2.5访问控制与安全策略S3提供了多种机制来控制对存储桶和对象的访问,包括:访问控制列表(ACLs):允许或拒绝特定用户对存储桶或对象的访问。存储桶策略:提供更精细的访问控制,可以应用于整个存储桶。IAM策略:通过AWSIdentityandAccessManagement(IAM)来控制用户和角色对S3资源的访问。加密:支持服务器端加密和客户端加密,确保数据在传输和存储过程中的安全。1.2.6示例:设置存储桶策略{

"Version":"2012-10-17",

"Statement":[

{

"Sid":"AllowPublicRead",

"Effect":"Allow",

"Principal":"*",

"Action":"s3:GetObject",

"Resource":"arn:aws:s3:::my-unique-bucket-name/*"

}

]

}1.2.7解释这段JSON代码定义了一个S3存储桶策略,它允许任何AWS用户(Principal为*)对存储桶my-unique-bucket-name中的所有对象执行GetObject操作,即读取对象。策略的Resource部分使用通配符*来指定所有对象。然而,出于安全考虑,通常不建议将存储桶设置为对公众开放,应根据实际需求限制访问权限。通过这些基本概念和组件的理解,以及示例代码的实践,你可以开始在AmazonS3上构建和管理你的数据存储解决方案,同时确保数据的安全性和隐私。2分布式存储系统:AmazonS3访问控制与安全策略2.1S3访问控制2.1.1ACLs访问控制列表2.1.1.1原理AmazonS3的ACLs(AccessControlLists)是一种用于管理对象和桶访问权限的机制。ACLs允许您指定谁可以访问您的S3资源,以及他们可以执行哪些操作。ACLs可以应用于桶或对象级别,提供了一种细粒度的访问控制方式。2.1.1.2内容ACLs的类型:S3支持两种类型的ACLs,分别是对象ACL和桶ACL。权限设置:ACLs可以设置读、写、读取ACL和写入ACL的权限。预设ACLs:AmazonS3提供了预设的ACLs,如public-read、authenticated-read、private和bucket-owner-full-control。2.1.1.3示例#导入boto3库

importboto3

#创建S3客户端

s3=boto3.client('s3')

#设置对象的ACL为public-read

response=s3.put_object_acl(

ACL='public-read',

Bucket='my-bucket',

Key='my-object'

)

#打印响应

print(response)此代码示例展示了如何使用boto3库设置S3对象的ACL为public-read,这意味着任何拥有对象URL的人都可以访问它。2.1.2BucketPolicy桶策略2.1.2.1原理BucketPolicy是一种JSON格式的策略文档,用于指定一组权限,这些权限应用于整个S3桶。通过BucketPolicy,您可以控制哪些AWS身份可以访问您的桶,以及他们可以执行哪些操作。2.1.2.2内容策略语法:BucketPolicy使用JSON格式,包括Sid、Effect、Principal、Action和Resource等字段。策略示例:例如,允许特定IAM用户读取桶中的所有对象。2.1.2.3示例{

"Version":"2012-10-17",

"Statement":[

{

"Sid":"AllowReadAccessToBucket",

"Effect":"Allow",

"Principal":{

"AWS":"arn:aws:iam::123456789012:user/MyUser"

},

"Action":"s3:GetObject",

"Resource":"arn:aws:s3:::my-bucket/*"

}

]

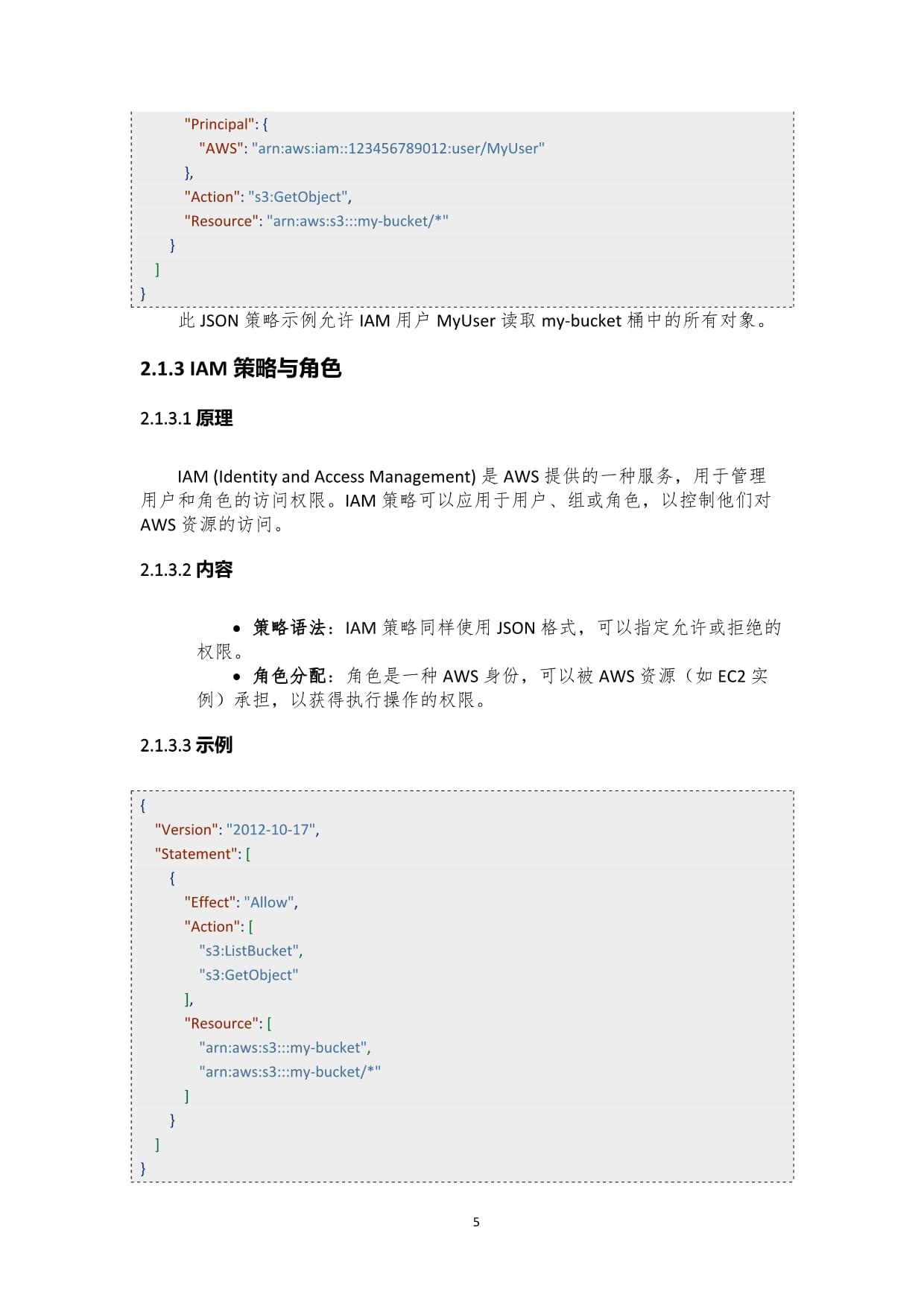

}此JSON策略示例允许IAM用户MyUser读取my-bucket桶中的所有对象。2.1.3IAM策略与角色2.1.3.1原理IAM(IdentityandAccessManagement)是AWS提供的一种服务,用于管理用户和角色的访问权限。IAM策略可以应用于用户、组或角色,以控制他们对AWS资源的访问。2.1.3.2内容策略语法:IAM策略同样使用JSON格式,可以指定允许或拒绝的权限。角色分配:角色是一种AWS身份,可以被AWS资源(如EC2实例)承担,以获得执行操作的权限。2.1.3.3示例{

"Version":"2012-10-17",

"Statement":[

{

"Effect":"Allow",

"Action":[

"s3:ListBucket",

"s3:GetObject"

],

"Resource":[

"arn:aws:s3:::my-bucket",

"arn:aws:s3:::my-bucket/*"

]

}

]

}此JSON策略示例允许承担该角色的实体列出my-bucket桶中的所有对象,并读取桶中的所有对象。2.2总结通过使用ACLs、BucketPolicy和IAM策略与角色,您可以对AmazonS3的访问进行精细控制,确保数据的安全性和合规性。这些机制提供了不同的访问控制粒度,可以根据您的需求灵活选择和应用。注意:上述代码和策略示例需要根据您的AWS账户和资源进行相应的修改和配置。在实际应用中,应遵循最小权限原则,仅授予执行任务所需的权限,以增强安全性。3分布式存储系统:AmazonS3:安全策略与最佳实践3.1数据加密方法在AmazonS3中,数据加密是保护数据安全的关键策略。S3提供了多种加密方式,包括服务器端加密(SSE)和客户端加密。服务器端加密由AmazonS3在数据存储时自动执行,而客户端加密则在数据上传前由应用程序执行。3.1.1服务器端加密服务器端加密可以使用AmazonS3管理的密钥(SSE-S3)、AWSKMS管理的密钥(SSE-KMS)或客户提供的密钥(SSE-C)。下面是一个使用SSE-KMS加密对象的Python示例:importboto3

s3=boto3.client('s3')

#使用SSE-KMS加密上传对象

response=s3.put_object(

Bucket='my-bucket',

Key='my-key',

Body='my-data',

ServerSideEncryption='aws:kms',

SSEKMSKeyId='my-kms-key-id'

)3.1.2客户端加密客户端加密允许您在数据上传到S3之前进行加密,确保数据在传输和存储过程中始终加密。以下是一个使用Python和PyCrypto库进行客户端加密的示例:fromCrypto.CipherimportAES

importboto3

importbase64

#初始化AES加密

cipher=AES.new('my-encryption-key',AES.MODE_ECB)

#加密数据

encrypted_data=cipher.encrypt('my-data')

#上传加密后的数据到S3

s3=boto3.client('s3')

response=s3.put_object(

Bucket='my-bucket',

Key='my-key',

Body=base64.b64encode(encrypted_data),

ServerSideEncryption='AES256'

)3.2访问日志与监控AmazonS3提供了日志记录和监控功能,帮助您跟踪和分析对S3存储桶的访问。通过启用S3服务器访问日志,您可以记录所有请求的详细信息,包括请求时间、请求者、请求类型等。3.2.1启用S3服务器访问日志以下是一个使用AWSCLI启用S3服务器访问日志的命令示例:awss3apiput-bucket-logging--bucketmy-bucket--logging-enabled'{"TargetBucket":"my-log-bucket","TargetPrefix":"access-logs/"}'3.2.2使用CloudWatch监控S3AmazonCloudWatch可以监控S3的指标,如请求次数、数据传输量等。以下是一个使用AWSSDKforPython(Boto3)获取S3指标的示例:importboto3

cloudwatch=boto3.client('cloudwatch')

#获取S3请求次数指标

response=cloudwatch.get_metric_statistics(

Namespace='AWS/S3',

MetricName='NumberOfRequests',

Dimensions=[

{

'Name':'BucketName',

'Value':'my-bucket'

},

{

'Name':'StorageType',

'Value':'AllStorageTypes'

},

],

StartTime='2023-01-01T00:00:00Z',

EndTime='2023-01-02T00:00:00Z',

Period=3600,

Statistics=['Sum'],

)3.3跨区域复制与灾难恢复跨区域复制是AmazonS3提供的一种灾难恢复策略,允许您将数据复制到另一个区域的S3存储桶中,以提高数据的持久性和可用性。3.3.1配置跨区域复制以下是一个使用AWSCLI配置跨区域复制的命令示例:awss3apiput-bucket-replication--bucketmy-bucket--replication-configurationfile://replication-config.json其中replication-config.json是一个包含复制规则的JSON文件,例如:{

"Role":"arn:aws:iam::123456789012:role/MyReplicationRole",

"Rules":[

{

"ID":"my-rule",

"Prefix":"my-prefix/",

"Status":"Enabled",

"Destination":{

"Bucket":"arn:aws:s3:::my-destination-bucket",

"StorageClass":"STANDARD"

}

}

]

}3.3.2测试跨区域复制为了确保跨区域复制正常工作,您可以上传一个对象到源存储桶,并检查它是否自动复制到目标存储桶。以下是一个使用Python和Boto3上传对象并检查复制状态的示例:importboto3

#上传对象到源存储桶

s3=boto3.client('s3')

response=s3.put_object(

Bucket='my-source-bucket',

Key='my-key',

Body='my-data',

)

#检查对象是否复制到目标存储桶

s3=boto3.client('s3',region_name='us-west-2')

response=s3.head_object(

Bucket='my-destination-bucket',

Key='my-key',

)

replication_status=response.get('ReplicationStatus','UNKNOWN')

print(f'Replicationstatus:{replication_status}')通过以上示例和策略,您可以有效地保护AmazonS3中的数据安全,监控访问活动,并实施灾难恢复计划。4高级安全特性4.1S3BucketAccessPoints访问点S3BucketAccessPoints,或称为S3访问点,是AmazonS3提供的一种高级安全特性,用于控制对S3存储桶的访问.它允许你为不同的应用程序或服务创建独立的访问点,每个访问点都有其特定的网络配置和访问控制策略.这种方式可以更精细地管理数据访问,提高安全性,并优化网络性能.4.1.1创建S3访问点importboto3

#创建S3客户端

s3=boto3.client('s3')

#创建S3访问点

response=s3.create_access_point(

Name='my-access-point',

VpcConfiguration={

'VpcId':'vpc-12345678',

'AllowedFeatures':['S3OnOutposts']

},

Policy='{"Version":"2012-10-17","Statement":[{"Effect":"Allow","Principal":"*","Action":"s3:*","Resource":"arn:aws:s3:us-east-1:123456789012:accesspoint/my-access-point/*"}]}'

)

#输出访问点的ARN

print(response['AccessPointArn'])4.1.2使用S3访问点S3访问点的使用通常需要通过其ARN进行,以下是一个使用S3访问点上传文件的示例:importboto3

#创建S3客户端

s3=boto3.client('s3')

#使用S3访问点上传文件

s3.upload_file(

Filename='path/to/your/file',

Bucket='arn:aws:s3:us-east-1:123456789012:accesspoint/my-access-point',

Key='your-file-key'

)4.2S3ObjectLock对象锁定S3ObjectLock是AmazonS3的另一项高级安全特性,它允许你锁定S3对象,防止其被意外删除或覆盖.这对于需要确保数据完整性和持久性的场景特别有用,例如法规遵从性或长期存档.4.2.1启用对象锁定在创建或更新存储桶时,可以启用对象锁定:importboto3

#创建S3客户端

s3=boto3.client('s3')

#启用对象锁定

s3.put_bucket_object_lock_configuration(

Bucket='my-bucket',

ObjectLockConfiguration={

'ObjectLockEnabled':'Enabled',

'Rule':{

'DefaultRetention':{

'Mode':'GOVERNANCE',

'Days':365

}

}

}

)4.2.2锁定对象锁定对象时,需要指定锁定模式和保留期:importboto3

#创建S3客户端

s3=boto3.client('s3')

#锁定对象

s3.put_object_lock_retention(

Bucket='my-bucket',

Key='my-object',

Retention={

'Mode':'GOVERNANCE',

'RetainUntilDate':datetime(2025,1,1)

}

)4.3S3StorageLens存储分析S3StorageLens是AmazonS3的分析工具,它提供了对存储桶活动的深入洞察,包括数据访问模式,存储使用情况,以及成本优化建议.这有助于你更好地理解数据存储和访问的效率,从而做出更明智的决策.4.3.1配置S3StorageLens配置S3StorageLens时,需要指定数据收集的范围和报告的接收方式:importboto3

#创建S3客户端

s3=boto3.client('s3')

#配置S3StorageLens

response=s3.put_storagelens_configuration(

StorageLensConfiguration={

'Id':'my-storage-lens',

'AccountLevel':{

'ActivityMetrics':{

'IsEnabled':True

},

'DetailedStatusCodesMetrics':{

'IsEnabled':True

},

'BucketLevel':{

'PrefixLevelMetrics':{

'IsEnabled':True,

'StorageClassAnalysis':{

'DataExport':{

'S3BucketDestination':{

'BucketAccountId':'123456789012',

'Format':'CSV',

'Prefix':'storagelens/reports/'

}

}

}

}

}

}

}

)4.3.2分析S3StorageLens报告S3StorageLens生成的报告可以被用来分析存储桶的使用情况和访问模式.以下是一个简单的示例,展示如何读取和解析S3StorageLens报告:importboto3

importcsv

#创建S3客户端

s3=boto3.client('s3')

#下载S3StorageLens报告

s3.download_file(

Bucket='my-report-bucket',

Key='storagelens/reports/report.csv',

Filename='local/report.csv'

)

#解析报告

withopen('local/report.csv','r')asfile:

reader=csv.reader(file)

forrowinreader:

print(row)通过上述示例,我们可以看到AmazonS3的高级安全特性如何帮助你更精细地控制数据访问,保护数据不被意外修改或删除,以及提供对存储桶活动的深入分析.这些特性对于构建安全,可靠,并且高效的数据存储解决方案至关重要.5实战演练与案例分析5.1设置S3Bucket的IAM策略在AmazonS3中,IAM(IdentityandAccessManagement)策略是控制谁可以访问您的S3存储桶以及他们可以执行哪些操作的关键工具。以下是如何设置一个S3Bucket的IAM策略的步骤,以及一个具体的代码示例。5.1.1步骤创建IAM策略:在AWS管理控制台中,通过IAM服务创建一个新的策略。定义策略文档:使用JSON格式定义策略文档,指定允许或拒绝的权限。附加策略:将策略附加到需要访问S3Bucket的IAM用户、组或角色上。5.1.2示例代码{

"Version":"2012-10-17",

"Statement":[

{

"Sid":"AllowListBucket",

"Effect":"Allow",

"Action":"s3:ListBucket",

"Resource":"arn:aws:s3:::my-bucket"

},

{

"Sid":"AllowGetObject",

"Effect":"Allow",

"Action":"s3:GetObject",

"Resource":"arn:aws:s3:::my-bucket/*"

}

]

}5.1.3解释Version:策略文档的版本,当前版本为2012-10-17。Statement:策略中的每个声明,可以有多个。Sid:声明的唯一标识符,可自定义。Effect:声明的效果,可以是Allow或Deny。Action:要允许或拒绝的AWS操作,如ListBucket和GetObject。Resource:操作将应用于的资源,使用ARN(AmazonResourceName)格式。5.2使用S3ObjectLock保护数据S3ObjectLock是一种功能,用于防止S3对象被意外删除或覆盖,确保数据的完整性和持久性。以下是如何使用S3ObjectLock的步骤和代码示例。5.2.1步骤启用ObjectLock:在S3存储桶的属性中启用ObjectLock。设置合规模式:选择合规模式,如GOVERNANCE或COMPLIANCE。设置保留期:为对象设置保留期,可以是天数或直到特定日期。5.2.2示例代码importboto3

#创建S3客户端

s3=boto3.client('s3')

#设置ObjectLock

response=s3.put_object_lock_configuration(

Bucket='my-bucket',

ObjectLockConf

温馨提示

- 1. 本站所有资源如无特殊说明,都需要本地电脑安装OFFICE2007和PDF阅读器。图纸软件为CAD,CAXA,PROE,UG,SolidWorks等.压缩文件请下载最新的WinRAR软件解压。

- 2. 本站的文档不包含任何第三方提供的附件图纸等,如果需要附件,请联系上传者。文件的所有权益归上传用户所有。

- 3. 本站RAR压缩包中若带图纸,网页内容里面会有图纸预览,若没有图纸预览就没有图纸。

- 4. 未经权益所有人同意不得将文件中的内容挪作商业或盈利用途。

- 5. 人人文库网仅提供信息存储空间,仅对用户上传内容的表现方式做保护处理,对用户上传分享的文档内容本身不做任何修改或编辑,并不能对任何下载内容负责。

- 6. 下载文件中如有侵权或不适当内容,请与我们联系,我们立即纠正。

- 7. 本站不保证下载资源的准确性、安全性和完整性, 同时也不承担用户因使用这些下载资源对自己和他人造成任何形式的伤害或损失。

最新文档

- 2021年陕西省部分高等职业院校自招生考试语文试卷(语文乙卷)A

- 红灯绿灯标志课件

- 六盘水师范学院《大学艺术英语》2023-2024学年第二学期期末试卷

- 广州软件学院《结构疲劳与断裂力学》2023-2024学年第一学期期末试卷

- 瑞昌市2025年三年级数学第二学期期末达标检测模拟试题含解析

- 山东省莱芜市2025年第二学期高三年级期末教学质量检测试题(一模)数学试题含解析

- 枣庄学院《教师语言艺术》2023-2024学年第一学期期末试卷

- 山西医科大学《现代医学基础》2023-2024学年第二学期期末试卷

- 伊犁师范大学《有氧健康舞蹈》2023-2024学年第一学期期末试卷

- 2025届江西省赣州市寻乌中学高三全国统一考试仿真卷(五)生物试题试卷含解析

- 【MOOC】数据库系统(中):建模与设计-哈尔滨工业大学 中国大学慕课MOOC答案

- 东北地方史 课件高三统编版(2019)历史二轮专题复习

- TSHSPS 001-2024 临床试验协调员管理及能力评估规范上海

- (高清版)DB34∕T 1489-2020 建筑起重机械安全评估实施规程

- 第十一届“大唐杯”新一代信息通信技术大赛(省赛)考试题及答案

- 2024年黑龙江省哈尔滨市中考英语真题(无答案)

- 中医内科学常用方剂方歌

- 财务主管岗位招聘笔试题及解答(某大型集团公司)

- 安徽省合肥市瑶海区2024年中考三模考试道德与法治历史试题-初中历史与社会(附答案解析)

- NB/T 11446-2023煤矿连采连充技术要求

- 我的动物朋友习作省公开课一等奖新名师课比赛一等奖课件

评论

0/150

提交评论