版权说明:本文档由用户提供并上传,收益归属内容提供方,若内容存在侵权,请进行举报或认领

文档简介

1.消息定义信息的通俗概念:消息就是信息,用文字、符号、数据、语言、音符、图片、图像等能够被人们感觉器官所感知的形式,把客观物质运动和主观思维活动的状态表达出来,就成为消息,消息中包含信息,消息是信息的载体。信号是表示消息的物理量,包括电信号、光信号等。信号中携带着消息,信号是消息的载体。信息的狭义概念(香农信息):信息是对事物运动状态或存在方式的不确定性的描述。信息的广义概念信息是认识主体(人、生物、机器)所感受的和表达的事物运动的状态和运动状态变化的方式。>语法信息(语法信息是指信息存在和运动的状态与方式。)>语义信息(语义信息是指信宿接收和理解的信息的内容。)>语用信息(语用信息是指信息内容对信宿的有用性。)2.狭义信息论、广义信息论。狭义信息论:信息论是在信息可以量度的基础上,对如何有效,可靠地传递信息进行研究的科学。它涉及信息量度,信息特性,信息传输速率,信道容量,干扰对信息传输的影响等方面的知识。广义信息论:信息是物质的普遍属性,所谓物质系统的信息是指它所属的物理系统在同一切其他物质系统全面相互作用(或联系)过程中,以质、能和波动的形式所呈现的结构、状态和历史。包含通信的全部统计问题的研究,除了香农信息论之外,还包括信号设计,噪声理论,信号的检测与估值等。自信息互信息定义性质及物理意义自信息量:I(x)=-logP(x)i xi是无量纲的,一般根据对数的底来定义单位:当对数底为2时,自信息量的单位为比特;对数底为e时,其单位为奈特;对数底为10时,其单位为哈特自信息量性质:I(x)是随机量;I(x)是非负值;I(x)是P(x)的单调递减函i i i i数。自信息物理意义:1.事件发生前描述该事件发生的不确定性的大小2•事件发生后表示该事件所含有(提供)的信息量互信息量:p(x|y)I(x;y)=I(x)-I(xIy)=-logp(x)+logp(xIy) (i=1,2,,n;j=1,2,,m)=log——i—j-ijiij i ij p(x)i互信息量的性质:1)互信息的对称性互信息可为零互信息可为正值或负值任何两个事件之间的互信息不可能大于其中任一事件的自信息互信息物理意义:1•表示事件yj出现前后关于事件xi的不确定性减少的量2•事件yj出现以后信宿获得的关于事件xi的信息量平均自信息性质平均互信息性质平均自信息(信息熵/信源熵/香农熵/无条件熵/熵函数/熵):H(X)=E[I(x)]=E-logpx)]=-^px)logp(x)i i i i熵函数的数学特性包括:对称性p=(p1p2…pn)各分量次序可调换确定性p中只要有为1的分量,H(p)为0非负性离散信源的熵满足非负性,而连续信源的熵可能为负。H(p)大于等于0扩展性扩展性说明,增加一个概率接近于零的事件,信源熵保持不变。虽然小概率事件出现后,给予收信者较多的信息,但从总体来考虑时,因为这种概率很小的事件几乎不会出现,所以它对于离散集的熵的贡献可以忽略不计。这也是熵的总体平均性的一种体现。连续性(6)递增性 ]]](7)极值性(最大离散熵定理)H(P,P,…,P)<H(—,,…,)=log"12nnn n⑻上凸性H(p1,p2…,pn)是概率分布(p1,p2…,pn)的严格上凸函数,即H[ap+(1-a)p']>aH(p)+(1-a)H(p')詹森不等式:如果f为一个上凸函数,X为一个随机变量,贝y:平均互信息i(x;y)=H(x)-H(xiy)=H(y)-H(rix)=H(x)+H(y)-H(xy)性质对称性:I(X;Y)=I(Y;X)非负性I(X;Y)>0极值性I(X;Y)<min{H(X),H(Y)}5•条件熵联合熵随机变量X和Y的条件熵定义为:H(XIY)=-ZZp(xiyj)logp(xiIyj)IJ 1JiJH(YIX)二-ZZP(xy)logp(yjIxi)=e[H(YIx.)]1J J1 iiJ条件熵表示已知一个随机变量时,对另一个随机变量的平均不确定性。条件熵:疑义度:mn mnH(X/Y)=£[7U/v;)]= =-工工心小咋PUj=1r=l >=1r=1噪声熵:nmH(Y/X)=E[I(y}/“)]= 工PgJlog2p(y}/兀)联合熵:联合熵表示对于二维随机变量的平均不确定性。H(XY)=E[/(at)]二-工pg,儿)logp(兀,儿)

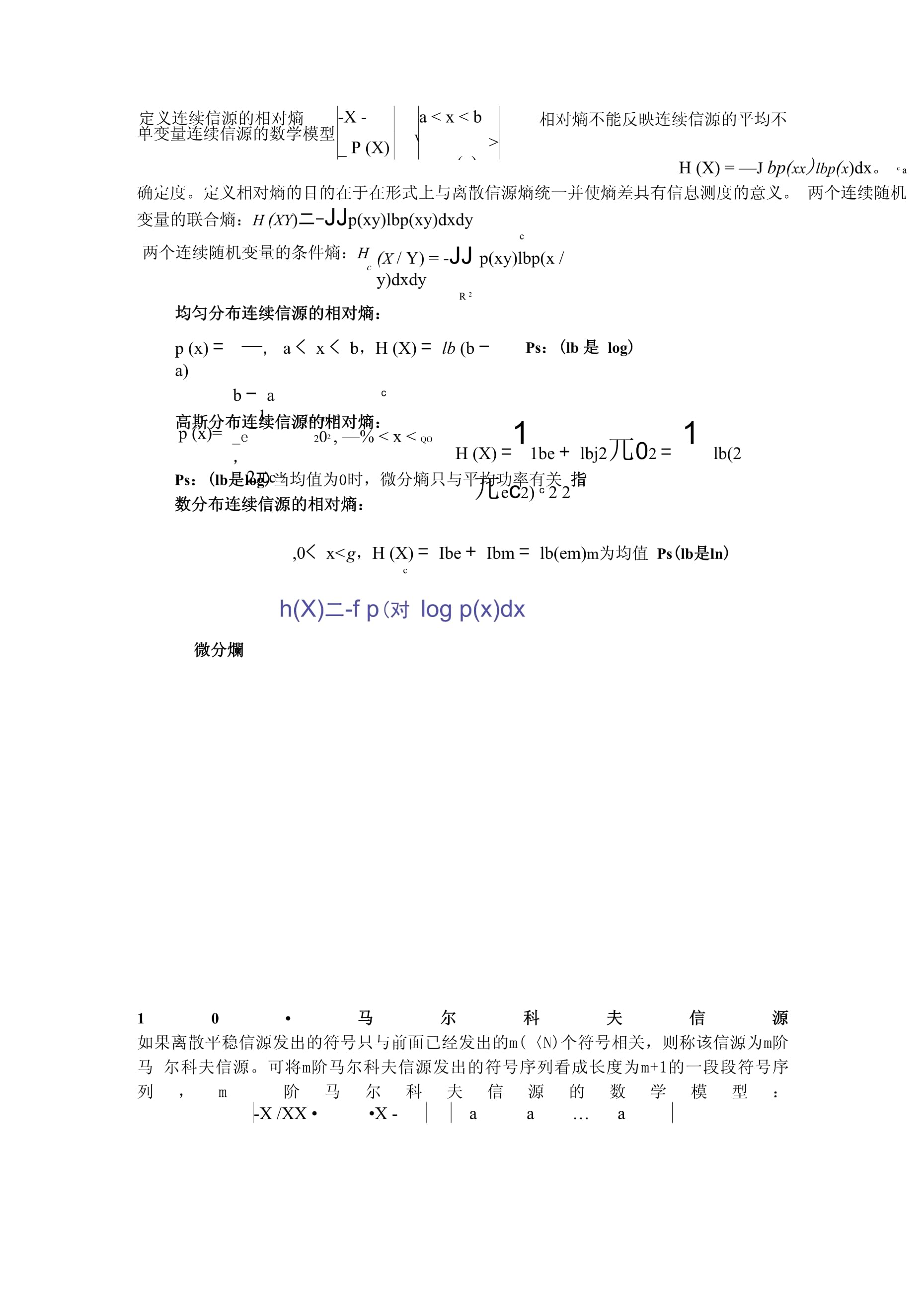

各种熵之间的关系•H(XY)=H(X)+H(Y|X)=H(Y)+H(X|Y)H(XIY)<H(X),H(YIX)<H(Y)H(XY)<H(X)+H(Y)若X与Y统计独立,则H(XY)=H(X)+H(Y)6.信源概率空间_X一xx ...x=i2 q_P(X)_p(x)1p(x) ... p(x)2q离散单符号信源X离散单符号信源X的概率空间:P(x.)>0 £p(x)=1iii=1离散多符号信源可以用随机矢量/随机变量序列来描述,即X=X1X2LXnL其中每个符号取值于同一个单符号信源空间:X:{x,x,…,x}1 2 q7.信源熵信源熵: H(X)=E[I(x)]=E[-logp(x)]= p(x)logp(x)i i i ii=1信息熵表示离散单符号信源的平均不确定性信源熵具有以下三种物理含意:-信息熵H(X)表示信源输出后,每个离散消息所提供的平均信息量。-信息熵H(X)表示信源输出前,信源的平均不确定性。-信息熵H(X)反映了变量X的随机性多符号与条件熵的关系条件熵随着N的增加是递减的N给定时平均符号熵>=条件熵H(X)>H(XIX...X)N N1 N-14.若H(4.若H(XI)vs则H|X...X)1 N-1=limH(X)=limH(X|X...X)1 N-1NTgN Ns NN次扩展信源的熵: H(X)=H(XN)=-^p(a)logp(a)iii=1离散平稳无记忆信源的N次扩展信源的熵等于离散单符号信源熵的N倍:H(X)=H(XN)=NH(X)离散平稳无记忆信源的熵率: H=limH(X)=lim-NH(X)=H(X)gNTgN NTgN连续信源熵-X-a<x<b_P(X)_V>p(x)单变量连续信源的数学模型定义连续信源的相对熵相对熵不能反映连续信源的平均不H(X)=—Jbp(xx)lbp(x)dx。c a定义连续信源的相对熵相对熵不能反映连续信源的平均不确定度。定义相对熵的目的在于在形式上与离散信源熵统一并使熵差具有信息测度的意义。两个连续随机变量的联合熵:H(XY)二-JJp(xy)lbp(xy)dxdyc两个连续随机变量的条件熵:Hc

(X/Y)=-JJp(xy)lbp(x/y)dxdyR2均匀分布连续信源的相对熵:p(x)= —,a<x<b,H(X)=lb(b-a)b-a c高斯分布连续信源的相对熵:Ps:(lb是log)p(x)=1 (x—m)2_e 202,—%<x<qo,2兀c2H(X)=11be+lbj2兀02=1lb(2兀ec2)c22Ps:(lb是log)当均值为0时,微分熵只与平均功率有关指数分布连续信源的相对熵:,0<x<g,H(X)=Ibe+Ibm=lb(em)m为均值Ps(lb是ln)c微分爛h(X)二-fp(对logp(x)dx10•马尔科夫信源如果离散平稳信源发出的符号只与前面已经发出的m(〈N)个符号相关,则称该信源为m阶马尔科夫信源。可将m阶马尔科夫信源发出的符号序列看成长度为m+1的一段段符号序列,m阶马尔科夫信源的数学模型:-X/XX••X-a a… am+1 1 2m=v1 2nm+1 aP(X /XX…X)p(a)p(a)…p(a)m+1 1 2mJ 1 2nm+1其中,a=x/xx•-•x,p(a)=p(x/xx•••x)i 'm+l‘1‘2it i 'm+1’1’2 Zm为强调m阶马尔科夫信源的长度特征,一般将其极限熵H记为H,即:8 m+1H=H =—艺艺p(e)p(e/e)lbp(e/e)g m+1 i ji jii=1j=1马尔科夫链的各态历经定理:其中p(e)>0,迟p(e)=1jjp(e)=更p(e)p(e/e),j=1,2,其中p(e)>0,迟p(e)=1jjj iji11.信道分类及转移概率矩阵信道分类•信道分类用户数量:单用户、多用户输入端和输出端关系:无反馈、有反馈信道参数与时间的关系:固参、时变参噪声种类:随机差错、突发差错输入输出特点:离散、连续、半离散半连续波形信道信道特性可以用转移概率矩阵来表示:「P11P12-P1JP二P21P22…P2JLpjipj2 -Pjj」12.信道容量的计算信道容量:>与信源的概率分布无关;>是完全描述信道特性的参量;>是信道能够传输的最大信息量。1信道单位时间内平均传输的最大信息量:C=-max{/(X;Y)}比特/秒一.按损耗分 P(X)无损信道:有噪无损信道,一个输入对应多个输出。信道矩阵每一列只有一个非0元素11P=005101011P=005101000H(X|Y)=0I(X;Y)=H(X)-H(XIY)=H(X)C=maxI(X;Y)=maxH(X)=logr(输入等概)p(x) p(x)H(X)<H(Y)101010P=0 101L0 1无噪信道:无噪有损信道,一个输出对应多个输入。信道矩阵每一行只有一个非0元素H(Y|X)=0I(X;Y)=H(Y)-H(Y|X)=H(Y)输出等概)C=maxI(X;Y)=maxH(Y)=logs输出等概)p(x) p(x)H(Y)<H(X)

100P=100P=001010H(YIX)二0,H(XIY)二0, r二sI(X;Y)=H(X)=H(Y)C=maxI(X;Y)=maxH(X)=logrp(x) p(x)Ps:r(输入)s(输出)二.按信道矩阵分称之为对称信道。1111111111111133_11111113 3 6 61111称之为对称信道。1111111111111133_11111113 3 6 611116 3 6 3对称信道,当信道输出概率分布为等概的情况下达到信道容量C=logs-H(p,,p,,…,p,)1 2 s其中plp2Lps是信道矩阵中的任意一行中的元素。2•行对称信道:若信道矩阵P中每行都是第一行的排列,则称此信道是行对称信道。111P=111C=maxH(Y)-H(p'...p')P=1111s3•强对称信道若r=s,且对于每一个输入符号,正确传输概率都相等,且错误传输概率p均匀地分配到r-1个符号,则称此信道为强对称信道或均匀信道。矩阵中的每一行都是第一行的排列;(行对称)矩阵中的每一列都是第一列的排列。(列对称)信道输入与输出消息(符号)数相等,即r=s。错误分布是均匀的:信道矩阵中正确传输概率都相等,且错误传输概率均匀地分配到r-1个符号上。不仅每一行元素之和为1,每一列元素之和也为1。显然,对称性的基本条件是1,而23、4是加强条件对于强对称信道有:C=logr0og(7)-砂)4•准对称信道。是行对称,信道矩阵可以按列分为一些对称的子阵,则称之为准对称信道。1316

对于离散准对称信道,当信道输入概率分布为等概的情况下达到信道容量:C=logrt-//(/71?/72A阳―乞MlcgA/左三•一般的离散信道(1由区p(y/x)lbp(y/x)=区p(y/x)P,k=1,2,…,n,求出P,j=1,2,…,mjk jk jkj jj=1 j=1(2)求出C=lb(区2Pj)(3)求出p(y)=2pj-C j=1,2,…,mj⑷由p(y)=£p(x)p(y/x) j=1,2,…,m,求出p(x)k=1,2,…,nj 带宽一定时,信道的最大传输率是信噪比的函数。 信噪比确定时,信道容量与带宽成正比。此时提高最大信息传输率的方法是提高带宽jik 带宽一定时,信道的最大传输率是信噪比的函数。 信噪比确定时,信道容量与带宽成正比。此时提高最大信息传输率的方法是提高带宽i=113•连续信源与波形信源的信道容量连续信源信道容量C=maxI(X;Y)=max[h(Y)-h(YIX)]=max[h(Y)-h(N)]=maxh(Y)-h(N)p(x) p(x) p(x) p(x)波形信源信道容量Q2当噪声是双边功率谱密度为N0/2的高斯白噪声时C=Blog(1+f)t Q2N14•香农公式香农公式S香农公式C=Wlog[1+—] 香农公式15•信源编码熵率15•信源编码熵率H=limH(X)g“ NH(X)=丄H(XX..X)N N 1 2N16•定长信源编码设离散平稳无记忆信源的熵为H(S),码符号集X中有r个码符号,码长为1,若对N次扩展信源 sN进行定长编码,则对于任意£>0,只要满足—>日(S)+*(也可改写为1logr>NH(S))Nlogr17•变长信源编码 Zqr-1.<1Kraft定理:即时码存在的充要条件是: 1—i=1

r是进制数,q是信源符号数l是码长。该不等式是惟一可译码存在的充要条件,而不是惟一可译码的充要条件当满足Kraft(或McMillan)不等式时,必然可以构造出即时码(或唯一可译码),否则不能构造出即时码(或唯一可译码)。 守…乙1McMillan定理:唯一可译码存在的充要条件是: —1i=118•香农第一编码定理•香农第一定理(变长无失真信源编码定理);设离散无诂忆信源的燔为H(S).它的TV版扩展信源为対,对扩展信源S"进行编码.总可以找到一种编码方法,构成唯一可译码,使平均碣长满足;空^鸟<迴+丄logrNlogrN19•冗余度以提高通信有效性为目的。通常通过压缩信源的冗余度来实现。采用的一般方法是压缩每个信源符号的平均比特数。冗余度,表示给定信源在实际发出消息时所包含的多余信息。它来自两个方面,一是信源符号间的相关性;二是信源符号分布的不均匀定义信息效率:H/X)

号集来说若有„_H川X)九(X)定义冗余度:H/X)

号集来说若有20•编码的步骤 |一唯一可译码,其平均码长小于所有其他唯一可最佳码厂二一唯一可译码,其平均码长小于所有其他唯一可-对于某一信源和某一码符译码的平均长度。紧致码香农(Shannon)费诺(Fano)哈夫曼(Huffma)二进制香农码的编码步骤如下:1)将符号元x按概率进行降序排列12)令p(x)=0,计算第jT个码字的累加概率:P(x)= p(x),J=1,2,…,N0 aJ i

确定第i个码字的码长k,满足下列不等式:—lbp(x)<k<-Ibp(x)+1i i i i将p(x)用二进制表示,取小数点后k位作为符号元x的码字。aj i i费诺编码费诺编码属于概率匹配编码编码步骤如下:⑴将概率按从大到小的顺序排列,令p(xl)2p(x2)三…三p(xn)按编码进制数将概率分组,使每组概率尽可能接近或相等。如编二进制码就分成两组,编m进制码就分成m组。给每一组分配一位码元将每一分组再按同样原则划分,重复步骤2和3,直至概率不再可分为止。哈夫曼(Huffman)编码将符号元按概率进行降序排列为概率最小的符号元分配一个码元1,概率次小的符号元分配一个码元0将概率最小的两个符号元合

温馨提示

- 1. 本站所有资源如无特殊说明,都需要本地电脑安装OFFICE2007和PDF阅读器。图纸软件为CAD,CAXA,PROE,UG,SolidWorks等.压缩文件请下载最新的WinRAR软件解压。

- 2. 本站的文档不包含任何第三方提供的附件图纸等,如果需要附件,请联系上传者。文件的所有权益归上传用户所有。

- 3. 本站RAR压缩包中若带图纸,网页内容里面会有图纸预览,若没有图纸预览就没有图纸。

- 4. 未经权益所有人同意不得将文件中的内容挪作商业或盈利用途。

- 5. 人人文库网仅提供信息存储空间,仅对用户上传内容的表现方式做保护处理,对用户上传分享的文档内容本身不做任何修改或编辑,并不能对任何下载内容负责。

- 6. 下载文件中如有侵权或不适当内容,请与我们联系,我们立即纠正。

- 7. 本站不保证下载资源的准确性、安全性和完整性, 同时也不承担用户因使用这些下载资源对自己和他人造成任何形式的伤害或损失。

最新文档

- 2026年时光的落幕黑金色年终汇报的魅力

- 2025年阳春公共卫生医院笔试及答案

- 2025年深圳教师事业编考试试题及答案

- 2025年-运营商通信类笔试及答案

- 2025年小学科学教师编笔试及答案

- 2026上海证券交易所员工招聘笔试模拟试题及答案解析

- 2025年兴安盟事业编公告笔试及答案

- 2025年红旗区事业编考试真题及答案

- 2026年《钻探技术的创新与发展趋势》

- 2026曲靖市事业单位公开招聘工作人员(889人)考试备考试题及答案解析

- 2025年网约车司机收入分成合同

- 2026年海南财金银河私募基金管理有限公司招聘备考题库参考答案详解

- 2026年GRE数学部分测试及答案

- 浙江省宁波市镇海中学2026届高二上数学期末教学质量检测模拟试题含解析

- (2025年)电力交易员练习试题附答案

- 2026年咨询工程师现代咨询方法与实务模拟测试含答案

- 甘肃省酒泉市2025-2026学年高一上学期期末语文试题(解析版)

- GB/T 3634.1-2025氢气第1部分:工业氢

- JJG 499-2021 精密露点仪检定规程

- T-CPQS A0011-2022 二手车车况检测及评估通则

- 吸毒的危害性后果

评论

0/150

提交评论