下载本文档

版权说明:本文档由用户提供并上传,收益归属内容提供方,若内容存在侵权,请进行举报或认领

文档简介

站名:站名:年级专业:姓名:学号:凡年级专业、姓名、学号错写、漏写或字迹不清者,成绩按零分记。…………密………………封………………线…………第1页,共1页海南政法职业学院《数据挖掘与商业智能》

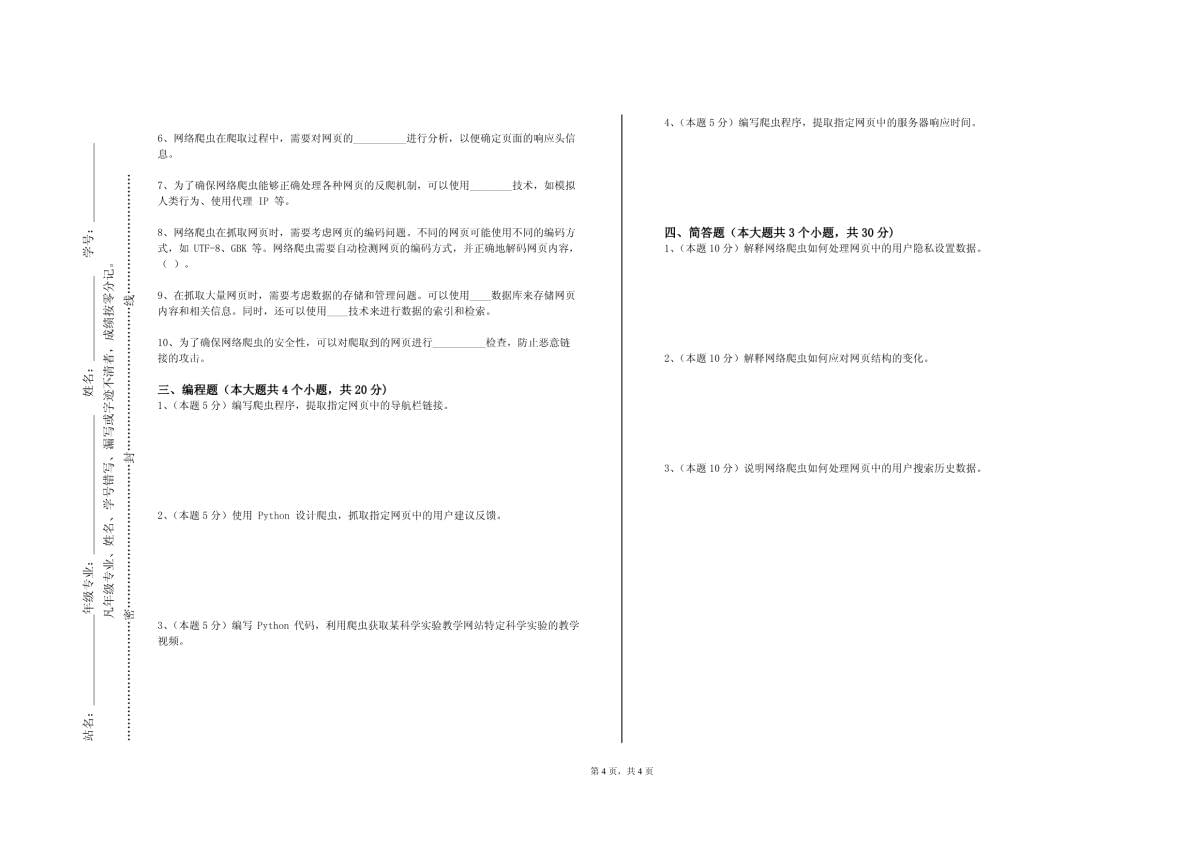

2023-2024学年第一学期期末试卷题号一二三四总分得分批阅人一、单选题(本大题共30个小题,每小题1分,共30分.在每小题给出的四个选项中,只有一项是符合题目要求的.)1、在网络爬虫的开发中,为了便于调试和测试,以下哪种工具和技术可能是有用的?()A.日志记录和分析B.单元测试框架C.模拟数据生成D.以上都是2、在网络爬虫的开发中,需要处理异常情况,如网络中断、服务器错误等。假设在爬取过程中遇到了网络中断,以下关于恢复爬取的描述,正确的是:()A.从中断的位置重新开始爬取,不重复之前的工作B.重新从头开始爬取,确保数据的完整性C.放弃本次爬取任务,等待网络恢复后再重新开始D.随机选择恢复爬取的位置,不遵循特定的规则3、在网络爬虫的运行过程中,如果发现爬取到的数据存在大量重复,以下哪种方法可能有助于去除重复数据?()A.使用哈希表进行数据去重B.随机删除部分重复数据C.保留最先获取的重复数据D.不进行任何处理,直接使用4、网络爬虫在处理网页中的链接时,需要进行筛选和过滤。假设要避免抓取一些无关或低质量的链接。以下关于链接筛选的描述,哪一项是错误的?()A.根据链接的域名、路径和参数等信息,判断其是否与目标数据相关B.利用正则表达式或规则引擎对链接进行匹配和过滤C.所有的链接都应该被抓取,然后再进行筛选和处理,以免遗漏重要数据D.可以参考网站的sitemap,获取重要页面的链接,优先抓取5、当网络爬虫需要登录目标网站获取特定的用户数据时,会面临一些挑战。假设要爬取一个需要登录才能访问的社交平台的用户好友列表,以下关于登录处理的方法,哪一项是最安全可靠的?()A.使用硬编码的用户名和密码进行登录B.模拟用户的登录操作,自动填写表单提交C.利用第三方登录接口,获取登录凭证D.跳过登录步骤,尝试从公开页面获取部分信息6、在设计网络爬虫时,需要考虑如何处理动态生成的网页内容。假设一个网站的部分数据是通过JavaScript加载的,以下哪种方法可以有效地获取这些动态生成的数据?()A.使用模拟浏览器的工具,如SeleniumB.分析JavaScript代码,手动重构数据获取逻辑C.放弃爬取动态数据,只获取静态页面内容D.直接发送HTTP请求获取数据7、网络爬虫在爬取数据时,需要遵守网站的robots.txt协议。以下关于robots.txt的叙述,不正确的是()A.robots.txt文件规定了网络爬虫可以访问和禁止访问的页面范围B.遵守robots.txt协议是网络爬虫的基本道德和法律要求C.即使网站的robots.txt禁止抓取某些页面,爬虫仍然可以强行获取数据D.一些网站可能没有robots.txt文件,此时爬虫需要谨慎判断抓取的合法性8、网络爬虫在处理网页中的链接时,需要决定哪些链接需要跟进抓取,哪些可以忽略。假设你正在爬取一个学术论文网站,以下关于链接选择的策略,哪一项是最有效的?()A.跟进所有遇到的链接,以获取全面的信息B.只跟进与当前主题相关的链接,如同一研究领域的论文链接C.随机选择一部分链接进行跟进,以控制抓取范围D.忽略所有链接,只抓取当前页面的内容9、当使用网络爬虫获取大量网页数据时,为了有效地存储和管理这些数据,以便后续的分析和处理。以下哪种数据存储方式可能是最合适的?()A.关系型数据库B.非关系型数据库C.文件系统D.分布式存储系统10、在网络爬虫抓取数据的过程中,需要考虑数据的合法性和道德性。例如,抓取受版权保护的内容或未经授权的个人数据是不被允许的。那么,以下哪种做法能够确保网络爬虫的活动符合法律和道德规范?()A.遵循网站的使用条款B.只抓取公开可访问的数据C.对抓取的数据进行匿名化处理D.以上都是11、在网络爬虫的开发中,需要对爬取到的数据进行清洗和预处理。假设数据中存在大量的噪声和错误,以下哪种数据清洗方法是最为有效的?()A.手动检查和修正数据B.使用正则表达式进行数据筛选C.利用机器学习算法进行数据清洗D.直接删除有问题的数据12、网络爬虫在爬取网页时,需要处理不同的编码格式。假设一个网页的编码格式不是常见的UTF-8,而是GBK,以下哪种方法可以正确地处理这种编码的网页内容?()A.在爬取时指定编码格式为GBKB.先以默认编码获取内容,然后尝试转换为其他编码C.忽略编码问题,直接处理获取到的内容D.放弃爬取该网页13、在进行网络爬虫开发时,需要考虑如何处理反爬虫机制。假设目标网站采用了验证码验证来防止爬虫,验证码形式复杂且频繁出现。为了突破这种限制,以下哪种方法可能是较为可行的?()A.手动输入验证码,虽然耗时但能保证准确性B.使用机器学习算法自动识别验证码,但准确率可能有限C.尝试绕过验证码验证的页面,获取其他可爬取的数据D.放弃爬取该网站,寻找没有验证码限制的网站14、网络爬虫在爬取网页时,需要对网页内容进行解析。假设要从一个HTML页面中提取特定的信息,以下关于网页解析方法的选择,正确的是:()A.使用正则表达式直接匹配所需信息,简单高效,但维护困难B.利用BeautifulSoup等库进行解析,虽然代码量较大,但准确性高C.自行编写HTML解析器,完全掌控解析过程,但开发难度大D.对于复杂的网页结构,不进行解析,直接获取整个页面的文本内容15、网络爬虫在运行时可能会遇到各种异常情况,如网络连接中断、页面无法访问等。假设你的爬虫在抓取过程中频繁遇到这些问题,以下关于异常处理的策略,哪一项是最重要的?()A.忽略异常,继续抓取下一个页面B.记录异常信息,稍后重新尝试抓取C.立即停止爬虫程序,等待问题解决后再重新启动D.降低抓取速度,以减少异常的发生16、在处理网络爬虫爬取到的数据时,如果数据存在噪声和错误,以下哪种数据清洗方法可能效果不佳?()A.基于规则的过滤和修正B.机器学习算法进行自动清洗C.手动逐一检查和修改D.直接忽略这些数据,不进行处理17、在网络爬虫的资源分配中,假设同时运行多个爬虫任务,每个任务有不同的优先级和资源需求。以下哪种资源分配策略可能更合理?()A.根据任务的优先级和资源需求动态分配资源B.平均分配资源给每个任务C.优先满足高优先级任务,其他任务等待D.随机分配资源,不考虑任务的特性18、网络爬虫在爬取网页时,可能会遇到网页结构的变化。假设一个网站突然更改了页面布局或元素的标识,导致爬虫无法正确提取数据。以下哪种方法可以应对这种情况?()A.及时更新爬虫的解析规则B.尝试使用其他更通用的解析方法C.暂停对该网站的爬取,等待网站恢复D.以上都是19、在网络爬虫爬取网页时,需要考虑如何处理网页中的链接。假设一个网页包含大量的链接,有的链接指向相关内容,有的是广告或无关页面。以下哪种链接处理策略可能更有效?()A.只爬取与主题相关的链接,过滤掉无关链接B.爬取所有链接,然后在后续处理中筛选数据C.随机选择一部分链接进行爬取D.不处理链接,只获取当前页面的内容20、在网络爬虫的开发中,需要考虑对目标网站的访问策略以避免违反相关规定和造成服务器负担。假设要爬取一个大型电商网站的商品信息,该网站有明确的爬虫规则和访问频率限制。为了在合法合规的前提下高效获取数据,以下哪种访问策略最为合适?()A.无视规则,以最快速度爬取B.严格按照网站规定的频率和规则进行爬取C.随机调整访问频率,尽量多获取数据D.先大量爬取,被封禁后再调整策略21、网络爬虫在抓取网页时,可能会遇到重定向的情况。假设一个网页多次重定向到不同的地址,以下关于处理重定向的策略,哪一项是最合理的?()A.跟随重定向,直到获取最终的目标页面B.限制重定向的次数,超过阈值则放弃抓取C.忽略重定向,只抓取初始页面D.随机选择是否跟随重定向22、网络爬虫在抓取网页时,需要处理页面中的JavaScript动态生成的内容。假设一个网站的重要数据是通过JavaScript加载的,以下关于处理这种情况的方法,哪一项是最合适的?()A.直接忽略JavaScript生成的内容,只抓取初始的HTMLB.使用无头浏览器模拟页面加载,获取完整内容C.尝试解析JavaScript代码,提取所需数据D.放弃抓取该网站,寻找其他数据源23、网络爬虫在大规模抓取时,需要考虑分布式部署。假设要构建一个分布式爬虫系统。以下关于分布式爬虫的描述,哪一项是不正确的?()A.可以将任务分配到多个节点上并行执行,提高抓取速度和效率B.需要一个中央协调器来管理任务分配、数据整合和节点监控C.分布式爬虫系统的搭建和维护非常简单,不需要考虑太多的技术细节D.节点之间需要进行有效的通信和数据共享,以保证爬虫任务的顺利进行24、网络爬虫在爬取网页时,需要处理各种类型的反爬虫验证码。假设遇到了一种基于图像识别的复杂验证码,以下哪种解决方法可能最有效?()A.手动输入验证码B.使用第三方验证码识别服务C.放弃爬取该网站D.尝试自动破解验证码25、当网络爬虫需要在多个线程或进程中并行运行以提高效率时,需要考虑线程安全和资源共享的问题。假设多个线程同时访问和修改同一个数据结构,以下哪种方法可以有效地避免冲突和数据不一致?()A.使用锁机制来同步对共享数据的访问B.每个线程使用自己独立的数据副本,避免共享C.不考虑线程安全,让冲突自然发生并处理异常D.减少线程数量,降低并发度以减少冲突的可能性26、网络爬虫在抓取网页时,需要处理不同的页面布局和结构。假设一个网站的页面结构经常变化,以下关于页面解析的方法,哪一项是最灵活的?()A.使用固定的HTML解析库,根据预设的规则提取数据B.基于机器学习的方法,自动学习页面的结构和数据模式C.人工编写针对每个页面的解析代码D.放弃抓取该网站,寻找结构稳定的数据源27、网络爬虫在运行过程中可能会遇到验证码的挑战。假设遇到一个需要手动输入验证码才能继续访问的网站,以下关于处理验证码的方法,正确的是:()A.尝试使用自动识别验证码的技术,绕过手动输入B.放弃抓取该网站的数据,寻找不需要验证码的网站C.雇佣大量人工手动输入验证码,以继续抓取D.对验证码不做任何处理,直接停止对该网站的抓取28、在网络爬虫的运行中,需要考虑数据的隐私保护。假设爬取到了涉及个人隐私的数据,以下关于隐私处理的描述,正确的是:()A.直接公开这些数据,以展示爬虫的成果B.对隐私数据进行匿名化处理后再使用C.保留隐私数据,但不进行传播D.忽略隐私问题,继续使用数据29、在网络爬虫的开发中,测试和调试是必不可少的步骤。假设爬虫程序出现了抓取结果不准确的问题,以下关于测试和调试的描述,哪一项是不正确的?()A.编写单元测试用例,对爬虫的各个功能模块进行单独测试B.使用调试工具,如断点调试和打印输出,定位问题所在C.测试和调试只在开发阶段进行,爬虫上线后就不再需要D.对修复后的问题进行回归测试,确保问题得到彻底解决30、网络爬虫在抓取网页时,可能会遇到页面重定向的情况。假设一个爬虫访问一个链接,被重定向到了另一个页面。以下关于处理页面重定向的描述,哪一项是不准确的?()A.爬虫程序需要能够自动跟踪重定向,获取最终的目标页面内容B.对于过多的重定向跳转,需要设置一个合理的限制,避免陷入无限循环C.重定向后的页面内容与原始请求的页面内容无关,可以忽略不处理D.分析重定向的原因和目标页面的性质,判断是否继续抓取二、填空题(本大题共10小题,每小题2分,共20分.有多个选项是符合题目要求的.)1、网络爬虫在存储爬取到的信息时,可以使用__________技术来对数据进行可视化展示,方便分析和理解。2、在网络爬虫程序中,可以使用________来设置爬取的并发连接数,控制爬虫对目标网站的访问压力。3、网络爬虫可以通过分析网页的用户行为来获取有价值的信息。例如,可以分析用户的点击流、搜索行为等。同时,还可以使用____技术来进行用户行为的建模和预测。4、为了更好地管理网络爬虫的任务,可以使用任务队列来存储和分配抓取任务。可以使用____数据库来实现任务队列,使用多个爬虫节点来并行执行任务。同时,还可以使用____技术来进行任务的调度和监控。5、网络爬虫抓取到的信息可以存储在多种数据存储中,如文件系统、数据库、分布式存储系统等。文件系统适合存储少量的数据,数据库适合存储大量结构化的数据,分布式存储系统则适合存储大

温馨提示

- 1. 本站所有资源如无特殊说明,都需要本地电脑安装OFFICE2007和PDF阅读器。图纸软件为CAD,CAXA,PROE,UG,SolidWorks等.压缩文件请下载最新的WinRAR软件解压。

- 2. 本站的文档不包含任何第三方提供的附件图纸等,如果需要附件,请联系上传者。文件的所有权益归上传用户所有。

- 3. 本站RAR压缩包中若带图纸,网页内容里面会有图纸预览,若没有图纸预览就没有图纸。

- 4. 未经权益所有人同意不得将文件中的内容挪作商业或盈利用途。

- 5. 人人文库网仅提供信息存储空间,仅对用户上传内容的表现方式做保护处理,对用户上传分享的文档内容本身不做任何修改或编辑,并不能对任何下载内容负责。

- 6. 下载文件中如有侵权或不适当内容,请与我们联系,我们立即纠正。

- 7. 本站不保证下载资源的准确性、安全性和完整性, 同时也不承担用户因使用这些下载资源对自己和他人造成任何形式的伤害或损失。

最新文档

- 教培行业社区谈判

- 备考2025年成人学位英语模拟测试题及答案解析2

- 河北正定师范高等专科学校《网页设计与制作》2023-2024学年第二学期期末试卷

- 张家口职业技术学院《影像解剖学》2023-2024学年第一学期期末试卷

- 闽西职业技术学院《嵌入式系统原理与应用技术》2023-2024学年第二学期期末试卷

- 温州职业技术学院《植物分子生物学》2023-2024学年第二学期期末试卷

- 重庆第二师范学院《建筑材料(安)》2023-2024学年第二学期期末试卷

- 预防关节挛缩

- 项目部年终总结及明年计划

- 2024陕西社区工作者练习题库完美版

- 《情志护理与养生》课件

- 植保无人机飞行作业服务应急及突发事件处理方案

- 2019地质灾害深部位移监测技术规程

- 《光电对抗原理与应用》课件第3章

- 智慧能源信息化平台建设整体解决方案

- 2024年税务系统职业技能竞赛试题库-社会保险费管理

- 2024年领导干部政治理论知识培训考试题库及答案(九)

- 企业行政管理的数字化趋势分析

- 推行注塑生产自动化改造计划

- GB/T 23444-2024金属及金属复合材料吊顶板

- 国家电网公司招聘高校毕业生应聘登记表

评论

0/150

提交评论